Compresión de datos

En Ciencias de la computación y teoría de la información, compresión de datos, codificación de fuente,[1] o reducción de tasa de bits implica codificación información usando menos brocas que la representación original.[2] La compresión puede ser lossy o Lossless. Compresión sin pérdida reduce bits mediante la identificación y eliminación de redundancia estadística. Ninguna información se pierde en compresión sin pérdida. Tipo de compresión reduce pedacitos identificar información innecesaria y sacándola.[3] El proceso de reducción del tamaño de un archivo de datos es popularmente como compresión de datos, aunque su nombre formal es fuente de codificación (codificación hecho en la fuente de los datos antes de que sea almacenada o transmitida).[4]

La compresión es útil porque ayuda a reducir el uso de recursos, como espacio de almacenamiento de datos o transmisión capacidad. Porque datos comprimidos deben ser descomprimidos para usar, este procesamiento adicional impone costos computacionales u otros a través de descompresión; esta situación está lejos de ser un almuerzo gratis. Compresión de datos está sujeto a un complejidad de espacio – tiempo trade-off. Por ejemplo, un esquema de compresión de vídeo puede requerir costosas hardware para el video para ser descomprimido lo suficientemente rápido como para ser visto como lo es ser descomprimido y la opción para descomprimir el video en su totalidad antes de ver puede ser un inconveniente o requieren almacenamiento adicional. El diseño de esquemas de compresión de datos implica ventajas y desventajas entre varios factores, incluyendo el grado de compresión, la cantidad de distorsión introducida)por ejemplo, cuando se utiliza compresión con pérdida de datos) y los recursos computacionales necesarios para comprimir y descomprimir los datos.[5]

Contenido

- 1 Lossless

- 2 Lossy

- 3 Teoría

- 3.1 Aprendizaje automático

- 3.2 Comparación de datos

- 4 Outlook y potenciales desaprovechados actualmente

- 5 Usos

- 5.1 Audio

- 5.1.1 Tipo de compresión de audio

- 5.1.1.1 Métodos de codificación

- 5.1.1.2 Discurso de codificación

- 5.1.2 Historia

- 5.1.1 Tipo de compresión de audio

- 5.2 Video

- 5.2.1 Teoría de codificación

- 5.2.2 Línea de tiempo

- 5.3 Genética

- 5.1 Audio

- 6 Véase también

- 7 Referencias

- 8 Enlaces externos

Lossless

Compresión sin pérdida de datos algoritmos suele explotar redundancia estadística para representar datos más concisa sin perder información, para que el proceso es reversible. Compresión sin pérdida es posible porque la mayoría datos del mundo real tienen redundancia estadística. Por ejemplo, una imagen puede tener áreas de color que no cambian en varios pixeles; en lugar de codificación "pixel rojo, rojo pixel,..." los datos pueden ser codificados como "279 pixeles rojos". Este es un ejemplo básico de codificación de funcionamiento-longitud; Existen muchos esquemas para reducir el tamaño del archivo eliminando redundancia.

El Lempel-Ziv Métodos de compresión (LZ) se encuentran entre los algoritmos más populares para el almacenamiento sin pérdidas.[6] DESINFLAR es una variación de LZ optimizada para ratio de compresión y velocidad de descompresión, pero la compresión puede ser lenta. DEFLATE se utiliza en PKZIP, Gzip y PNG. LZW (Lempel-Ziv-Welch) se utiliza en GIF imágenes. También es destacable el algoritmo LZR (Lempel-Ziv – Renau), que sirve como base para el Zip método. LZ métodos utilizan un modelo de compresión basados en tablas donde las entradas de tabla son sustituidas por repetidas secuencias de datos. Para métodos más LZ, esta tabla se genera dinámicamente de datos anteriores en la entrada. Suele ser la propia mesa Codificada Huffman (e.g. SHRI, LZX). Es un esquema de codificación actual LZ-basada que se desempeña bien LZX, utilizado en Microsoft TAXI formato.

Usan de los mejores compresores lossless modernos probabilística modelos, tales como predicción por coincidencia parcial. El Transformación de Burrows-Wheeler también puede considerarse como una forma indirecta de modelado estadístico.[7]

La clase de gramatical basado en códigos están ganando popularidad porque puede comprimir texto muy repetitivo, extremadamente eficaz, por ejemplo, colección de datos biológicos de especies iguales o conexas, colección enorme documento versionados, archivos de internet, etc.. La tarea básica de códigos basados en la gramática está construyendo una gramática libre de contexto que se derivan de una sola cadena. Sequitur y volver a vincular los algoritmos de compresión Gramática práctica para que el públicos códigos están disponibles.

En un refinamiento adicional de estas técnicas, las predicciones estadísticas pueden acoplarse a un algoritmo llamado codificación aritmética. Codificación aritmética, inventado por Jorma Rissanen, y se convirtió en un método práctico de Witten, Neal y Cleary, logra compresión superior para el algoritmo de Huffman más conocida y se presta especialmente bien para las tareas de compresión de datos adaptable donde las predicciones son fuertemente dependientes del contexto. Codificación aritmética es utilizada en la norma de compresión de imagen binivel JBIGy la norma de compresión de documento DjVu. El sistema de entrada de texto Dasher es un codificador aritmético inverso.[8]

Lossy

Compresión con pérdida de datos es lo contrario de compresión sin pérdida de datos. En estos esquemas, cierta pérdida de información es aceptable. Dejando los detalles del origen de datos puede ahorrar espacio de almacenamiento. Esquemas de compresión con pérdida de datos son informados por la investigación sobre cómo la gente percibe los datos en cuestión. Por ejemplo, el ojo humano es más sensible a las variaciones sutiles en luminancia que es a las variaciones de color. JPEG compresión de imagen trabaja en parte por el redondeo de los bits de información.[9] Hay una correspondiente trade-off entre preservación de información y reducir el tamaño. Un número de formatos de compresión populares explotar estas diferencias perceptuales, incluyendo los que se utilizan en la música archivos, imágenes y video.

Lossy compresión de imagen puede ser utilizado en cámaras digitales, para aumentar la capacidad de almacenamiento con una mínima degradación de calidad de imagen. Del mismo modo, DVD ' s uso del lossy MPEG-2 Códec de vídeo para compresión de vídeo.

En pérdidas compresión de audio, métodos de psicoacústica se utilizan para eliminar los componentes no-audible (o menos audibles) de la señal de audio. La compresión del lenguaje humano a menudo se realiza con las técnicas más especializadas; discurso de codificación, o codificación de voz, a veces se distingue como una disciplina independiente de compresión de audio. Aparecen en diversos estándares de compresión de audio y voz códecs de audio. Compresión de voz se utiliza en Telefonía por Internet, por ejemplo la compresión de audio se utiliza para CD ripping y es decodificada por reproductores de audio.[10]

Teoría

La base teórica de la compresión es proporcionada por teoría de la información (que está estrechamente relacionado con teoría algorítmica de la información) para la compresión sin pérdidas y teoría de tarifa – distorsión por compresión con pérdida. Estas áreas de estudio fueron falsificadas esencialmente por Claude Shannon, que publica documentos fundamentales sobre el tema en finales de 1940 y 1950. Teoría de la codificación también está relacionado. La idea de compresión de datos está profundamente relacionada con inferencia estadística.[11]

Aprendizaje automático

Hay una estrecha relación entre aprendizaje automático y compresión: un sistema que predice el probabilidades posteriores de una secuencia dada su historia entera puede utilizarse para la compresión de datos óptima (utilizando codificación aritmética de la distribución de salida) mientras que un compresor óptima puede usarse para la predicción (por encontrar el símbolo que comprime mejor, dada la historia anterior). Esta equivalencia se ha utilizado como justificación para la compresión de datos como punto de referencia para la "inteligencia general".[12]

Comparación de datos

Compresión de datos puede considerarse como un caso especial de comparación de datos:[13][14] Comparación de datos consiste en producir un diferencia dado un fuente y un blanco, con parches produciendo un blanco dado un fuente y un diferencia, mientras que la compresión de datos consiste en producir un archivo comprimido, dado un objetivo, y descompresión consiste en producir un objetivo dado sólo un archivo comprimido. Por lo tanto, se puede considerar compresión de datos como comparación de datos con datos de fuente vacía, el archivo comprimido correspondiente a una "diferencia de nada". Esto es lo mismo que considerar absoluta entropía (correspondiente a la compresión de datos) como un caso especial de entropía relativa (correspondiente a comparación de datos) sin datos iniciales.

Cuando uno desea hacer hincapié en la conexión, se puede usar el término compresión diferencial para referirse a la comparación de datos.

Outlook y potenciales desaprovechados actualmente

Se estima que la cantidad total de los datos que están almacenados en dispositivos de almacenamiento del mundo podría comprimirse más con algoritmos de compresión existentes por un factor promedio restante de 4. Se estima que la capacidad tecnológica combinada del mundo para almacenar la información proporciona 1.300 exabytes de hardware dígitos en 2007, pero cuando el correspondiente contenido óptimo es comprimido, esta sólo representa 295 exabytes de Información de Shannon.[15]

Usos

Audio

Compresión de datos de audio, como distinguido de compresión de rango dinámico, tiene el potencial de reducir la transmisión ancho de banda y los requisitos de almacenamiento de datos de audio. Algoritmos de compresión de audio se implementan en software como audio codecs. Algoritmos de compresión de audio con pérdida proporcionan la mayor compresión a costa de fidelidad y se utilizan en numerosas aplicaciones de audio. Casi todos estos algoritmos se basan en psicoacústica para eliminar el menos sonidos audibles o significativos, reduciendo así el espacio requerido para almacenar o transmitir.[16]

En tanto con pérdida y sin pérdida de compresión, redundancia de información se reduce, usando métodos tales como codificación, reconocimiento de patrones, y predicción lineal para reducir la cantidad de información utilizada para representar los datos sin comprimir.

El equilibrio aceptable entre la pérdida de calidad de audio y transmisión o almacenamiento de tamaño depende de la aplicación. Por ejemplo, uno 640MB disco compacto (CD) contiene aproximadamente una hora de comprimir alta fidelidad música, menos de 2 horas de música comprimida losslessly, o 7 horas de música comprimida en el MP3 formato en un medio tasa de bits. Una grabadora digital de sonido normalmente puede almacenar alrededor de 200 horas de discurso claramente inteligible en 640MB.[17]

Compresión de audio sin pérdidas produce una representación de datos digitales que descomprimen a un duplicado exacto de digital de la corriente del audio original, a diferencia de la reproducción de las técnicas de compresión sin pérdida como Vorbis y MP3. Relaciones de compresión son unos 50 – 60% del tamaño original,[18] que es similar a los de compresión de datos lossless genérico. Es incapaz de lograr relaciones de compresión alta debido a la complejidad de la compresión sin pérdida formas de onda y los rápidos cambios en las formas de los sonidos. Codecs como FLAC, Acortar y TTA uso predicción lineal para estimar el espectro de la señal. Muchos de estos algoritmos se utiliza convolución con el filtro [1-1] ligeramente blanquear o aplanar el espectro, permitiendo la compresión sin pérdida tradicional trabajar más eficientemente. El proceso se revierte a la descompresión.

Cuando son para ser procesados, por compresión adicional o para archivos de audio edición, es deseable trabajar desde un original sin cambios (sin comprimir o losslessly comprimido). Procesamiento de un archivo comprimido reealizarse para algún propósito generalmente produce un resultado final inferior a la creación del mismo archivo comprimido de un original sin comprimir. Además de sonido editar o mezclar, compresión de audio sin pérdidas es de uso frecuente para el almacenamiento de archiving, o como copias del maestros.

Existe un número de formatos de compresión de audio sin pérdidas. Acortar era un formato sin pérdida temprano. Las más recientes incluyen Free Lossless Audio Codec (FLAC), Apple Apple Lossless (ALAC), ALS MPEG-4Microsoft Windows Media Audio 9 Lossless (WMA Lossless), Audio del mono, TTA, y WavPack. Ver lista de los códecs lossless para un listado completo.

Algunos formatos de audio cuentan con una combinación de un formato con pérdida y una corrección sin pérdidas; Esto permite despojar la corrección para obtener fácilmente un archivo lossy. Estos formatos incluyen SLS MPEG-4 (Escalable a Lossless), WavPack, y OptimFROG DualStream.

Otros formatos están asociados con un sistema distinto, tales como:

- Transferencia de corriente directa, utilizado en Super Audio CD

- Meridian Lossless Packing, utilizado en DVD-Audio, Dolby TrueHD, Blu-ray y HD DVD

Tipo de compresión de audio

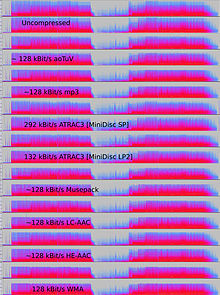

Tipo de compresión de audio se utiliza en una amplia gama de aplicaciones. Además de las aplicaciones directas (reproductores de mp3 o equipos), flujos de audio digital comprimidos se utilizan en la mayoría video DVD, televisión digital, medios de transmisión en el Internet, transmisiones vía satélite y radio cable y cada vez más en radio terrestre. Tipo de compresión alcanza típicamente compresión mucho mayor que la compresión sin pérdidas (datos del 5% y 20% de la secuencia original, en lugar de 50 a 60 por ciento), descartando datos menos críticos.[19]

La innovación de tipo de compresión de audio era usar psicoacústica reconocer que no todos los datos en un flujo de audio pueden ser percibidos por el ser humano sistema auditivo. Más tipo de compresión reduce redundancia perceptual primeros identificación perceptivamente irrelevantes sonidos, es decir, sonidos que son muy difíciles de escuchar. Ejemplos típicos incluyen altas frecuencias o sonidos que se producen al mismo tiempo que suena más fuerte. Esos sonidos son codificados con exactitud disminuida o en absoluto.

Debido a la naturaleza de los algoritmos con pérdida, calidad de audio sufre cuando un archivo se descomprime y recomprimido)pérdida de generación digital). Esto hace que tipo de compresión no aptos para almacenar los resultados intermedios en aplicaciones de ingeniería de audio profesionales, como edición de sonido y grabación multipista. Sin embargo, son muy populares entre los usuarios finales (particularmente MP3) que puede almacenar un megabyte por valor de un minuto de música en calidad adecuada.

Métodos de codificación

Para determinar qué información en una señal de audio es perceptivamente irrelevante, algoritmos de compresión con pérdida más utilizan transformaciones como la transformada de coseno discreta modificada (MDCT) para convertir dominio de tiempo formas de onda muestreadas en un dominio de transformación. Una vez transformado, típicamente en el dominio de la frecuencia, pueden asignar frecuencias componente brocas según cómo audibles son. Audibilidad de componentes espectrales calculada usando la umbral absoluto de audiencia y los principios de enmascarar simultáneo— el fenómeno en el que una señal es enmascarada por otra señal separados por frecuencia — y, en algunos casos, enmascaramiento temporal— donde una señal está enmascarada por otra señal separados por tiempo. Contornos de igual volumen puede usarse también para ponderar la importancia perceptiva de los componentes. Modelos de la combinación de oreja-cerebro humano incorporar estos efectos a menudo se denominan modelos psicoacústicos.[20]

Otros tipos de compresores con pérdidas, tales como la codificación predictiva lineal (LPC) utilizado con discurso, codificadores basada en origen. Estos codificadores utilizan un modelo de generador de sonido (por ejemplo, el aparato vocal humano con LPC) para blanquear la señal de audio (es decir, aplane su espectro) antes de Cuantización. LPC puede ser considerado como una técnica de codificación perceptual básica: reconstrucción de una señal de audio utilizando un predictor lineal formas ruido de cuantización del codificador en el espectro de la señal, parcialmente lo enmascara.[21]

Lossy formatos se utilizan a menudo para la distribución de streaming de audio o interactivas aplicaciones (por ejemplo, la codificación de voz para la transmisión digital en las redes de telefonía celular). En estas aplicaciones, deben ser descomprimidos los datos como los flujos de datos, en lugar de después de la secuencia de datos entera ha sido transmitida. No todos los códecs de audio pueden ser utilizados para aplicaciones de streaming, y para tales usos un codec diseñado para flujo de datos efectivamente serán generalmente elegidos.[22]

Resultados de latencia de los métodos utilizados para codificar y descodificar los datos. Algunos códecs analizará un segmento más largo de los datos para optimizar la eficiencia y luego código de manera que requiera un mayor segmento de datos al mismo tiempo para decodificar. (A menudo codecs crear segmentos llamados un "marco" para crear segmentos de datos discretos para la codificación y descodificación). La inherente latencia del algoritmo de codificación puede ser crítico; por ejemplo, cuando hay una transmisión bidireccional de datos, tales como con una conversación telefónica, retrasos significativos pueden seriamente degradar la calidad percibida.

En contraste con la velocidad de compresión, que es proporcional al número de operaciones requeridas por el algoritmo, latencia se refiere al número de muestras que deben analizarse antes de un bloque de audio es procesado. En el caso mínimo, la latencia es cero muestras (por ejemplo, si el codificador/decodificador simplemente reduce el número de bits utilizados para cuantificar la señal). Algoritmos de dominio de tiempo como LPC también suelen tienen bajas latencias, de ahí su popularidad en discurso de codificación de telefonía. En algoritmos tales como MP3, sin embargo, un gran número de muestras a analizar para implementar un modelo psicoacústico en el dominio de la frecuencia y latencia es del orden del 23 ms (ms 46 para una comunicación bidireccional)).

Discurso de codificación

Discurso de codificación es una categoría importante de compresión de datos audio. Los modelos perceptivos para estimar lo que oyes una oreja humana generalmente son algo diferentes de los utilizados para la música. La gama de frecuencias necesarias para transmitir el sonido de una voz humana son normalmente mucho más estrechas que las que necesitaba para la música y el sonido es normalmente menos complejo. Como resultado, discurso puede ser codificado en alta calidad con una velocidad relativamente baja.

Si los datos que se comprimirá están analógicos (por ejemplo un voltaje que varía con el tiempo), cuantización se emplea para digitalizarlo en números (normalmente enteros). Esto se conoce como conversión de analógico a digital (A/d). Si los enteros generados por cuantización son 8 bits cada uno, entonces toda la gama de la señal analógica se divide en intervalos de 256 y todos los valores de la señal dentro de un intervalo son quantized al mismo número. Si se generan enteros de 16 bits, entonces la gama de la señal analógica se divide en intervalos de 65.536.

Esta relación ilustra el compromiso entre (un gran número de intervalos analógicos) de alta resolución y alta compresión (pequeños enteros generados). Esta aplicación de cuantización es utilizada por varios métodos de compresión de discurso. Esto se logra, en general, mediante una combinación de dos enfoques:

- Sólo codificación de sonidos que podían ser hechos por una sola voz humana.

- Tirando por la borda más de los datos de la señal — mantener suficiente para reconstruir una voz "inteligible" más que el rango de frecuencia completa del ser humano audiencia.

Quizás fueron los primeros algoritmos utilizados en discurso de codificación (y compresión de datos audio en general) el Algoritmo de ley y el algoritmo µ-law.

Historia

Un compendio de literatura para una gran variedad de sistemas de codificación de audio fue publicado en la revista IEEE sobre áreas seleccionadas en las comunicaciones (JSAC), febrero de 1988. Aunque hubo algunos papeles de antes de ese tiempo, esta colección documentada una variedad entera de acabado, trabajando audio codificadores, casi todos ellos usando perceptual (es decir, enmascarar) algún tipo de análisis de frecuencia y back-end de codificación silencioso y técnicas.[23] Varios de estos papeles resaltó la dificultad de obtener buena, limpio digital audio para fines de investigación. La mayoría, si no todos, de los autores en la edición de JSAC eran también activa en el Comité de Audio MPEG-1.

Primer comercial de todo el mundo transmiten automatización sistema de compresión de audio fue desarrollado por Oscar Bonello, un profesor de ingeniería en el Universidad de Buenos Aires.[24] En 1983, usando el principio psicoacústico del enmascaramiento de bandas críticos publicado por primera vez en 1967,[25] empezó a desarrollar una aplicación práctica basada en el recientemente desarrollado IBM PC Computadoras y el sistema de automatización de emisión fue lanzado en 1987 bajo el nombre de Audicom. Veinte años después, casi todas las estaciones de radio en el mundo estaban usando una tecnología similar fabricada por varias empresas.

Video

Compresión de vídeo utiliza técnicas modernas de codificación para reducir la redundancia de los datos de vídeo. Mayoría algoritmos de compresión de vídeo y codecs combinar espacial compresión de imagen y temporal compensación de movimiento. Compresión de vídeo es una aplicación práctica de la codificación de fuente en la teoría de la información. En la práctica, la mayoría de codecs de video también utilizar técnicas de compresión de audio en paralelo para comprimir las secuencias de datos separados, pero combinados como un paquete.[26]

Uso de la mayoría de los algoritmos de compresión de vídeo tipo de compresión. Vídeo sin comprimir requiere una muy alta tarifa de datos. Aunque compresión sin pérdida de vídeo codecs realizan una compresión media de sobre factor 3, un típico MPEG-4 tipo de compresión video tiene un factor de compresión entre 20 y 200.[27] Como en todo tipo de compresión, existe un trade-off entre calidad de video, costo de las necesidades de compresión y descompresión y sistema de procesamiento. Vídeo altamente comprimido puede presentar visible o distracción artefactos.

Algunos esquemas de compresión de vídeo funciona normalmente en grupos de forma cuadrada de los vecinos pixeles, a menudo llamado macrobloques. Estos grupos de píxeles o bloques de píxeles se comparan de un marco a otro y el Códec de compresión de vídeo envía solamente el diferencias dentro de esos bloques. En las áreas de video con más movimiento, la compresión debe codificar más datos para mantenerse al día con el mayor número de píxeles que están cambiando. Comúnmente durante las explosiones, las llamas, rebaños de animales y en un paneo disparos, los cables de alta frecuencia detalle calidad disminuye o aumenta en el velocidad de bits variable.

Teoría de codificación

Datos de vídeo pueden ser representados como una serie de marcos de imagen todavía. Contiene la secuencia de marcos espaciales y temporales redundancia ese intento de algoritmos de compresión de vídeo para eliminar o código en un tamaño más pequeño. Las semejanzas pueden ser codificadas por almacenar sólo las diferencias entre fotogramas o mediante funciones perceptivos de la visión humana. Por ejemplo, las pequeñas diferencias de color son más difíciles de percibir que son cambios en el brillo. Algoritmos de compresión pueden tener como promedio un color a través de estas áreas similares para reducir el espacio, de una manera similar a los utilizados en JPEG compresión de imágenes.[28] Algunos de estos métodos son inherentemente lossy mientras que otros pueden conservar toda la información relevante de la original, vídeo sin comprimir.

Una de las más poderosas técnicas para la compresión de vídeo es la compresión interfotograma. Compresión interfotograma utiliza uno o más fotogramas antes o después de una secuencia para comprimir el marco actual, mientras que la compresión intracuadro utiliza sólo el marco actual, siéndole compresión de imagen.[29]

El más poderoso había utilizado método comparando cada fotograma del vídeo con la anterior. Si el marco contiene áreas donde nada se ha movido, el sistema simplemente emite un comando corto que copia esa parte de la estructura anterior, poco a poco, en el otro. Si secciones del marco se mueven de una manera simple, el compresor emite un comando (un poco más largo) que dice el descompresor para desplazar, girar, aclarar u oscurecer la copia. Este comando más sigue siendo mucho más corto que la compresión intracuadro. Compresión interfotograma funciona bien para programas que simplemente reproducirán por el espectador, pero pueden causar problemas si la secuencia de vídeo debe ser editado.[30]

Porque interfotograma compresión copia datos de un fotograma a otro, si el marco original es simplemente recortar (o perdido en la transmisión), los cuadros siguientes no pueden ser reconstruidos correctamente. Algunos formatos de vídeo, tales como DV, comprimir cada fotograma independientemente usando compresión intracuadro. Hacer 'cortes' en video comprimido intracuadro es casi tan fácil como edición de vídeo sin comprimir: uno encuentra el principio y el final de cada fotograma y simplemente copias bit a bit cada marco que uno quiere mantener y descartes los fotogramas uno no quiere. Otra diferencia entre interfotograma compresión intracuadro es que, con los sistemas intracuadro, cada fotograma utiliza una cantidad similar de datos. En mayoría de los sistemas interfotograma, ciertos Marcos (tales como"Yo Marcos"en MPEG-2) no están permitidas para copiar datos desde otros marcos, así que necesitan mucho más datos que otros fotogramas cercanos.[31]

Es posible construir a un editor de vídeo basados en computadoras manchas problemas causados cuando que Marcos se editan hacia fuera mientras otros marcos de necesitan. Esto ha permitido que nuevos formatos como HDV para ser utilizado para la edición. Sin embargo, este proceso exige mucha más potencia de cálculo de edición intracuadro comprime vídeo con la misma calidad de imagen.

Hoy, casi todos utilizan métodos de compresión de vídeo (por ejemplo, las normas aprobaron por el UIT-T o ISO) aplicar una transformada de coseno discreta (DCT) para la reducción de redundancia espacial. SES que es ampliamente utilizado en este sentido fue presentado por N. AhmedNatarajan T. y K. Rao R. en 1974.[32] Otros métodos, tales como compresión fractal, matching pursuit y el uso de un transformada wavelet discreta (DWT) han sido objeto de algunas investigaciones, pero normalmente no se utilizan en productos prácticos (excepto para el uso de Wavelet de codificación como codificadores de imagen fija sin compensación de movimiento). Interés en compresión fractal parecen estar disminuyendo, debido a recientes análisis teórico, mostrando una falta comparativa de la eficacia de tales métodos.[33]

Línea de tiempo

La tabla siguiente es una historia parcial de las normas internacionales de compresión de vídeo.

| Año | Estándar | Editor | Implementaciones populares |

|---|---|---|---|

| 1984 | CONCABINA | UIT-T | |

| 1988 | H.261 | UIT-T | Videoconferencia, videotelefonía |

| 1993 | MPEG-1 parte 2 | ISO, IEC | Video-CD |

| 1995 | H.262/MPEG-2 parte 2 | ISO, IEC, UIT-T | DVD Video, Blu-ray, Difusión de vídeo digital, SVCD |

| 1996 | H.263 | UIT-T | Videoconferencia, videotelefonía, Video en teléfonos móviles)3GP) |

| 1999 | MPEG-4 parte 2 | ISO, IEC | Video en Internet)DivX, XviD ...) |

| 2003 | H.264/MPEG-4 AVC | SONY, Panasonic, Samsung, ISO, IEC, UIT-T | Blu-ray, HD DVD Difusión de vídeo digital, iPod Video, Apple TV, |

| 2009 | VC-2 (Dirac) | SMPTE | Video en Internet, difusión de HDTV, TVEAD |

| 2013 | H.265 | ISO, IEC, UIT-T |

Genética

Algoritmos de compresión genética es la última generación de algoritmos lossless que comprimir datos (típicamente secuencias de nucleótidos) usando los algoritmos de compresión convencional y algoritmos genéticos adaptados para el tipo de datos específico. En 2012, un equipo de científicos de la Universidad Johns Hopkins publicó un algoritmo de compresión genética que no usa un genoma de referencia para la compresión. HAPZIPPER fue diseñado para HapMap datos y logra una solucíon compresión (95% de reducción en el tamaño del archivo), proporcionando 2 a 4 veces mejor compresión y en un tiempo mucho más rápido que las utilidades de compresión para fines generales principales. Para ello, Chanda, Elhaik y Bader MAF introducido basado en codificación (MAFE), lo que reduce la heterogeneidad del conjunto de datos clasificando SNPs por su frecuencia menor alelo, homogeneizando así el conjunto de datos.[34] Otros algoritmos en 2009 y 2013 (DNAZip y GenomeZip) tienen relaciones de compresión de hasta 1200 veces — permitiendo 6 billones basepair diploide genomas humanos debe almacenarse en 2,5 megabytes (comparados con un genoma de referencia o promediados sobre muchos genomas).[35][36]

Véase también

|

|

Esto"Véase tambiénsección" puede contener un número excesivo de sugerencias. Por favor asegúrese de que se dan sólo las sugerencias más relevantes y que no son enlaces rojoy considerar la integración de sugerencias en el propio artículo. (Noviembre de 2011) |

- Enmascarar auditivo

- Corpus de Calgary

- Corpus de Canterbury

- Contexto de mezcla

- Artefactos de compresión

- Simetría de compresión de datos

- Codificador de Diccionario

- Codificación de fuente distribuido

- Distribución diádica

- Compresión dinámica de Markov

- Elias codificación gamma

- Codificación de la entropía

- Codificación de Fibonacci

- Codificación Golomb

- Compresión HTTP

- Complejidad de Kolmogorov

- Algoritmo de compresión mágica

- Longitud mínima descripción

- Código modulo-N

- Gama de codificación

- Sub banda de codificación

- Código universal (compresión de datos)

- Cuantización vectorial

Referencias

- ^ Wade, Graham (1994). Codificación y procesamiento de la señal (2 ed.). Cambridge University Press. p. 34. ISBN978-0-521-42336-6. 2011-12-22. "El objetivo general de codificación de fuente es explotar o eliminar redundancia"ineficiente"en el PCM fuente y así lograr una reducción de la tasa general de fuente R."

- ^ Mahdi, O.A.; Mohammed, M.A.; Mohamed, A.J. (noviembre de 2012). "Implementación de un nuevo enfoque de una compresión de Audio convertir texto de codificación mediante técnica híbrida". International Journal of Computer Science temas 9 (6, no. 3): 53 – 59. 06 de marzo de 2013.

- ^ Pujar, J.H.; Kadlaskar, L.M. (mayo de 2010). "Un nuevo método sin pérdida de imagen de compresión y descompresión usando técnicas de codificación Huffman". Diario de tecnologías de la información teórica y aplicada 15 (1): 18 – 23.

- ^ Salomon, David (2008). Una concisa introducción a la compresión de datos. Berlín: Springer. ISBN9781848000728.

- ^ Tanque, M.K. (2011). Implementación de Limpel-Ziv algoritmo de compresión sin pérdida mediante VHDL. ThinkQuest 2010: Actas de la primera Conferencia Internacional sobre contornos de tecnología de la computación. Berlín: Springer. PP. 275-283.

- ^ Navqi, Saud; Naqvi, R.; Riaz, R.A.; Siddiqui, f el. (abril de 2011). "RTL optimizado diseño e implementación del algoritmo LZW para aplicaciones de alto ancho de banda". Revisión eléctrica 2011 (4): 279-285.

- ^ Mahmud, Salauddin (marzo de 2012). "Un método de compresión de datos mejorada para datos generales". Revista Internacional de investigación científica y la ingeniería 3 (3): 2. 06 de marzo de 2013.

- ^ Mahmud, Salauddin (marzo de 2012). "Un método de compresión de datos mejorada para datos generales". Revista Internacional de investigación científica y la ingeniería 3 (3): 2. 06 de marzo de 2013.

- ^ Arcangel, Cory. "En la compresión". 06 de marzo de 2013.

- ^ Mahmud, Salauddin (marzo de 2012). "Un método de compresión de datos mejorada para datos generales". Revista Internacional de investigación científica y la ingeniería 3 (3): 2. 06 de marzo de 2013.

- ^ Marak, Laszlo. "En la compresión de la imagen". Universidad de Marne la Vallee. 06 de marzo de 2013.

- ^ Mahoney, Matt. "Fundamentos para una referencia de compresión de texto grande". https://CS.Fit.edu/~mmahoney/. Florida Institute of Technology. 05 de marzo de 2013.

- ^ Korn, et al., D. "RFC 3284: la diferenciación genérica a VCDIFF y formato de compresión de datos". Internet Engineering Task Force. 05 de marzo de 2013.

- ^ Korn, D.G.; Vo, K.P. (1995), B. Krishnamurthy, ed., Vdelta: Comparación y compresiónSoftware Unix reutilizables práctico, Nueva York: John Wiley & Sons, Inc.

- ^ Hilbert, Martin; López, Priscila (01 de abril de 2011). "La capacidad del mundo tecnológico a tienda, comunicar y computar información". Ciencia 332 (6025): 60 – 65. Doi:10.1126/science.1200970. PMID21310967. 06 de marzo de 2013.

- ^ Mahdi, O.A.; Mohammed, M.A.; Mohamed, A.J. (noviembre de 2012). "Implementación de un nuevo enfoque de una compresión de Audio convertir texto de codificación mediante técnica híbrida". International Journal of Computer Science temas 9 (6, no. 3): 53 – 59. 06 de marzo de 2013.

- ^ La grabadora de voz digital Olympus WS-120, según su manual, puede almacenar unas 178 horas de discurso-calidad de audio en.Formato WMA en 500MB de memoria flash.

- ^ Coalson, Josh. "Comparación FLAC". 06 de marzo de 2013.

- ^ Jaiswal, R.C. (2009). Ingeniería de audio y Video. Pune, Maharashtra: Nirali Prakashan. p. 3.41. ISBN9788190639675.

- ^ Faxin Yu, Luo Hao, Zheming Lu (2010). Procesamiento y análisis de modelo tridimensional. Berlín: Springer. p. 47. ISBN9783642126512.

- ^ Jaiswal, R.C. (2009). Ingeniería de audio y Video. Pune, Maharashtra: Nirali Prakashan. p. 3.43. ISBN9788190639675.

- ^ Jaiswal, R.C. (2009). Ingeniería de audio y Video. Pune, Maharashtra: Nirali Prakashan. p. 3.43. ISBN9788190639675.

- ^ IEEE Journal en áreas seleccionadas en comunicaciones. Codificación de las comunicaciones de voz 6 (2). de febrero de 1988 https://www.JSAC.UCSD.edu/TOC/1988/feb88.html

|URL =(falta de títuloAyuda). 06 de marzo de 2013. - ^ "Resumen de algunas de las contribuciones de Solidyne a Broadcast Engineering". Breve historia de Solidyne. Buenos Aires: Solidyne. 06 de marzo de 2013.

- ^ Zwicker, et al., Eberhard (publicado originalmente en 1967; Traducción Publicada en 1999). El oído como un receptor de comunicación. Melville, NY: Acoustical Society of America.

- ^ "Codificación de vídeo". Centro de investigación de procesamiento de la información y señal. Georgia Institute of Technology. 06 de marzo de 2013.

- ^ Gráficos & Media Lab Video Group (2007). Comparación de códecs de vídeo sin pérdidas. Universidad Estatal de Moscú.

- ^ Lane, Tom. "Compresión de imágenes JPEG FAQ, parte 1". FAQ de Internet Archives. Independent JPEG Group. 06 de marzo de 2013.

- ^ Faxin Yu, Luo Hao, Zheming Lu (2010). Procesamiento y análisis de modelo tridimensional. Berlín: Springer. p. 47. ISBN9783642126512.

- ^ Bhojani, D.R. "4.1 Video Compression". Hipótesis. 06 de marzo de 2013.

- ^ Jaiswal, R.C. (2009). Ingeniería de audio y Video. Pune, Maharashtra: Nirali Prakashan. p. 3.55. ISBN9788190639675.

- ^ Ahmed, N.; Natarajan, T.; Rao, K.R. (enero de 1974). "Transformada de coseno discreta". IEEE Transactions on Computers C – 23 (1): 90-93. Doi:10.1109/T-C.1974.223784. 06 de marzo de 2013.

- ^ Faxin Yu, Luo Hao, Zheming Lu (2010). Procesamiento y análisis de modelo tridimensional. Berlín: Springer. p. 47. ISBN9783642126512.

- ^ Chanda P, Bader JS, Elhaik E (27 de julio de 2012). "HapZipper: compartir las poblaciones HapMap sólo fue más fácil". Investigación de ácidos nucleicos 40 (20): e159. Doi:10.1093/nar/gks709. PMC3488212. PMID22844100.

- ^ Christley S, Y Lu, Li C, Xie X (15 de enero de 2009). "Genomas humanos como archivos adjuntos de correo electrónico". Bioinformática 25 (2): 274 – 5. Doi:10.1093/Bioinformatics/btn582. PMID18996942.

- ^ Pavlichin DS, Weissman T, Yona G (septiembre de 2013). "El genoma humano contratos de nuevo". Bioinformática 29 (17): 2199 – 202. Doi:10.1093/Bioinformatics/btt362. PMID23793748.

Enlaces externos

- Fundamentos de la compresión de datos (Video)

- Compresión de vídeo 4:2:2 de 10 bits y sus beneficios

- ¿Por qué guarda 10 bits de ancho de banda (incluso cuando el contenido es 8-bit)?

- ¿Qué tecnología de compresión debe utilizarse

- Wiley - Introducción a la teoría de compresión

- Pruebas subjetivas escucha EBU en baja-bitrate audio codecs

- Guía de archivo audio: Formatos de música (Guía para ayudar a un usuario elige el codec correcto)

- MPEG 1 y 2 Introducción de compresión de video (formato pdf) en el Wayback Machine (archivados 28 de septiembre de 2007)

- comparación de hydrogenaudio wiki

- Introducción a la compresión de datos por Guy E Blelloch de CMU

- Saludos HD - 1080p sin comprimir material de investigación y ensayos de compresión

- Explicación del método de compresión sin pérdida señal utilizada por la mayoría de codecs

- Pruebas de escucha ciegas interactivas de códecs de audio por internet

- TestVid - 2.000 + HD y otro sin compresión video clips fuente para ensayos de compresión

- Videsignline - Introducción a la compresión de vídeo

- Tecnología de reducción de la huella de datos

|

||||||||||||||||||||||||||||||||||||||||||||||||||||||

|

||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

|

||||||||||||||||||||||||||||||||||||||||||||||||||||||||||